应用爆发之年:聊聊模型技术进化与商业化

本文来自微信公众号:硅谷101,采访:泓君,图文:泓君、朱婕,头图来自:AI生成

两年前“硅谷101”在播客里聊大模型的时候,大家的普遍感受还“有意思,但不好用”——幻觉、慢、贵,总觉得离真正的生产力还差那么几步。

2026年,变化比想象中来得更快。阿里云千问大模型业务总经理徐栋告诉“硅谷101”,一个五六人的小团队现在用AI一天能生成6000条广告视频,成本压到10元以下,低于市场售价20至50元——商业闭环已经跑通了。AI漫剧也在爆发,国内短剧市场规模已经超过电影市场,视频生成模型正从5秒进化到15秒,年底有望突破1分钟。

成本端的变化更加剧烈。徐栋分享了一组数字:千问的推理成本正以每半年接近10倍的速度下降,推理速度从30-50 TPS飙升到80-100+,首包延迟从2秒降到500毫秒。他说,今天端侧4B的小模型,能力已经超过两年前最大的闭源模型,70%以上的通用任务可以在手机和车机上本地处理。

2025年被很多人称为“AI应用元年”。如果说前两年的关键词是“模型能做什么”,那今年所有企业都在问同一个问题——用AI,到底划不划算?

本期内容,“硅谷101”邀请了阿里云千问大模型业务总经理徐栋、影石Insta360研究院总监亓鲁教授、语忆科技联合创始人兼CEO吕瀛杰,一起拆解大模型在商业前线“开荒”的逻辑、成本和隐藏关卡。

以下是这次对话内容的精选:

一、模型的技术进步与商业化

泓君:在2025年底到2026年初,大家讨论最多的一个是AI Agent,还有一个就是AI应用,真的开始走进大家的生活了。今天很开心请你能跟大家聊一聊大模型在商业化方向的一些趋势。在此之前,你要不要先简单介绍一下你在阿里的工作,以及你主要负责什么?

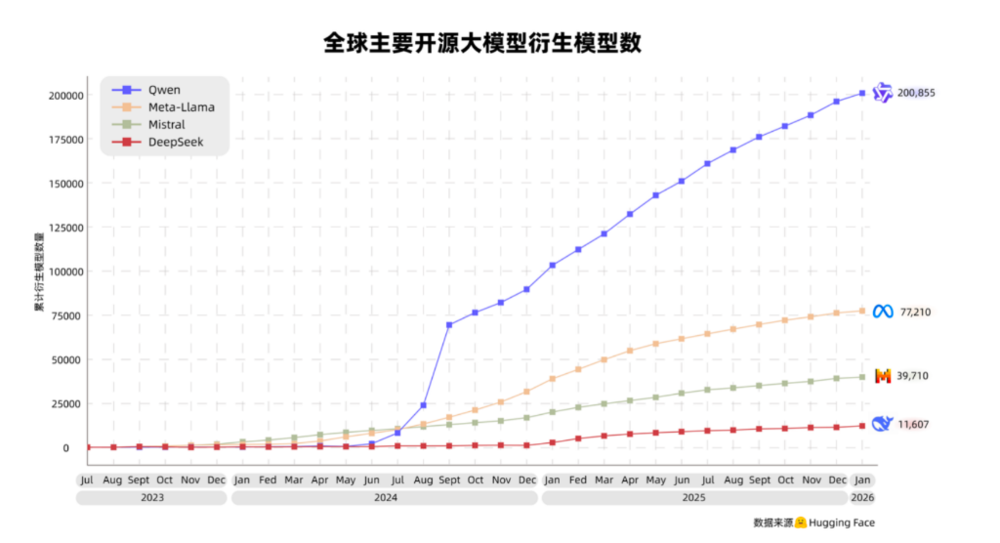

徐栋:阿里做大模型时间比较久了,最早的模型可以追溯到2021年左右。首先有一个在海外尤其有名的模型叫千问,英文名叫Qwen。在开源领域,它已经是一个体量非常大的模型,很多北美公司也会用它作为基座模型。它代表的是我们的语言模型,我们会用它去挑战AI的智慧,看看它能不能用更多工具、进入更多生产环节。这是我们非常主力的一个模型。

第二个是视觉生成类的模型,叫万相,英文名叫Wan,它可以生成图片、视频,也能做图片和视频的编辑,同时也有成为未来世界模型的范式的可能性。最近三个月我们重点发布了2.5的preview版和2.6版,在视频创作方面收到了很多新反馈。

第三个基础模型是去年云栖大会发布的Fun,一个纯音频模型,它涵盖ASR、TTS,也包括声音克隆。我们在这个模型上追求更拟真、支持多语言、不同方言和口音,让它能更好地理解和表达。

我们的模型还是比较结构化的。在这几个基座模型基础上,我们开始与很多客户交流合作,包括制造业、实体企业、品牌商,还有很多互联网公司。但最近一年,我的感受是出现了大量AI Native公司,它们通过模型取得了不错的成果,在很多碎片化的市场里实现了非常好的ROI。

泓君:你刚刚提到了几个大模型。你觉得过去2025年,模型技术最重要的进化是在哪几个方向?

徐栋:最近半年进化特别多。以“万相Wan”为代表的视频生成模型,如果类比GPT-3.5到4的状态,我认为它已经达到了GPT-4的水平。过去视频生成模型更多用于特效、娱乐,但现在它可以进入生产领域,比如最近很火的AI漫剧,增长速度非常快,还有自动化生成广告视频。很多15秒的切片广告已经开始自动化生成,形成完整管线,可能五个人一天就能生成6000个视频,这是一个非常明显的趋势。

从技术角度看,有几个特点很有意思:

第一,生成时间变长了。视频生成从过去的5秒、10秒,进入15秒时代,未来可能到一分钟,这样内容连贯性会更好。

第二,镜头语言更丰富。模型可以切换不同镜头,调整光影效果,接近专业影视级能力,用户通过简单提示词就能实现。

第三,角色一致性保持(Carry)能力。这是受Sora2启发,在角色扮演中,保持人物、物体、背景、音色的一致性,也就是“保ID”,让后续创作有更好延展空间。

简单来说,我们希望从15秒进一步延长生成时长,目前我们已经做到国内最长的视频生成模型;让镜头切换、光影变化这些原本需要专业导演、摄像、美术协作的能力,现在通过模型门槛大大降低;最后,角色扮演,保持一致的能力,我相信会成为未来所有视频生成模型的标配。

泓君:角色扮演具体是指什么?

徐栋:举个例子:你可以用手机自拍一段5秒钟视频,抬头或转头,说几句话,类似试镜。模型输入这段视频后,可以对人物形象和声音进行“保ID”,后续创作中这个形象和声音可以被复刻出来。

泓君:也就是说以后只需要真人出镜5秒,后面的内容可以由AI生成、模型化运作。

徐栋:对,这意味着生成内容的可控性更高。以前可能依赖抽卡(随机生成),现在可以在输入端提供更多参考维度,在动漫创作领域其实挺多的,以前是参考图,现在开始参考视频。

泓君:你刚刚提到,比如五个人一天可以生成6000个视频,AI漫剧也比较火了,你觉得基于模型能力提升,你看到哪些比较好的商业化案例或应用?

徐栋:国内短剧市场已经超过电影市场。在视频宣传方面,很明显短剧从原来的真人拍摄或大量人工编辑,开始有一定比例转向AI生成。最近最火的是漫剧,它从动态漫发展过来的,剧情连贯,商业化能力强,已经成为与AI结合的一个典型。

泓君:像短剧市场、AI生成短剧、真人IP短剧,还有批量生成AI广告,大家最关心的问题是,用AI做的成本和用人做的成本分别是多少?厂商在考虑接入模型时看重什么?

徐栋:现在按品质分为S级、A级、B级。一部短剧,如果成本合理,AI可能能做到2万元以下,加上投流和ROI计算,有可能打正或实现不错收入。如果对精品要求更高,需要投入更多后期制作资源,成本会更高,但剧集品质也会更好。

广告方面,15秒视频的AI成本可以控制在10元到15元以下,在市场上有比较好的商业空间。一般来说,一个合格的15秒广告市场价在25元到50元之间,这样就形成了较好的商业循环。

泓君:这个成本确实挺低的。阿里有淘宝电商生态的,是这些电商卖家在用AI做广告吗?

徐栋:这个结构是比较复杂的。现在每个流量平台会给广告主或代理公司一定的编辑能力,以匹配其平台。广告主自己也有大量素材,可能是自己做的,也可能是第三方代理公司做的。在广告生成方面,有可能是代理公司做,也可能是代理公司分包给AI Native的创业公司做。这类创业公司越来越多,它们将万相和千问模型结合成管线,形成刚才说的五六个人一天生成6000个广告的能力,再交给代理公司或流量平台的广告组。

泓君:挺有意思的。这是视频生成模型方面。你们还有音频生成模型和千问模型,你觉得另外两个模型在2025年有哪些进步和突破?

徐栋:语言模型正在发生持续而深刻的变化,虽然我们很难再看到一个巨大的范式上的改变,我简单说一下我们在做的事情。

第一,高质量数据集越来越少,大家都在精耕细作,通过调整数据顺序、角度,提升模型知识学习效率,使模型在一些corner case(边缘案例)上表现越来越好。

第二,模型结构会越来越稀疏,多Token预测(MTP)等技术在不同模型中实践,速度会更快,甚至成倍提升。未来首包响应可能从2秒缩短到500毫秒都是有可能的,TPS可能从30-50提升到80-100以上,在性能要求高的场景下表现就会变得非常棒。

其实大家也可以从机器吞吐角度来去理解,模型稀疏化后,推理成本也会下降,可能以一个量级下降。

此外,指令遵循能力、Agent能力(尤其是工具调用)、上下文长度等都在持续迭代。叠加coding能力提升,未来可能会出现大量连续运行的Agent,它不像今天的Chatbot那样,马上给我个结果,而是能利用闲时计算资源做AI for science研究或生成深度报告,这背后它可能调用检索引擎、CRM、ERP等工具。如果它会用了这么多工具,我们相信输出质量一定会比纯文本模型更好。

泓君:你讲了很多基础模型在细微点上的提升。去年我们追踪大模型和Agent发展趋势时,注意到2025年是AI从模型走向应用的关键一年,Agent大爆发,中国应用创新尤其活跃。为什么是去年这个时间点?是因为模型基础能力提升,还是有其他关键点推动?

徐栋:第一是推理能力。2024年底OpenAI推出o1后,模型不再依赖所谓的概率,开始表现出逻辑偏好,这是我觉得是非常根本性的改变。

第二是模型规模变大,原本存在的挑战是你训不动它,但通过预训练改进,模型变大的同时可控性也提高了,复杂指令能力越来越强。以前依赖确定性的workflow,但现在模型指令遵循和理解能力增强,只要有准确上下文,就能在泛化性和准确性之间找到平衡。

第三是工具调用(Tool Use)。随着Claude Skills、MCP等标准逐渐被大家接受,越来越多工具显性化,今天的模型开始跳脱了输入输出窗口,开始进入更多生产环节。这个环节可能不是一个框,而是一个标准的SaaS流程或硬件交互方式。

泓君:我注意到刚刚结束的CES展上有一个趋势,所有产品都想与AI搭上关系,比如耳机、智能眼镜、剪辑拍摄工具等。今年有很多中国客户参展,背后也有千问大模型的影子。你能否聊聊,在AI硬件产品中,大模型扮演什么角色?

徐栋:模型与硬件结合不是新鲜事,早在十年前,ASR、CV模型都与硬件有关,但商业价值不大。这一次,我觉得最重要的是,模型变得更拟人,可以执行更多任务了。以前只能识别,现在能听懂、看懂,给出你想要的结果。今天通过千问App,你可以通过自然语言直接订咖啡、订座位等。如果是眼镜,通过自然语言完成这些任务,就跟过去是很大的区别。这背后离不开语音、视觉理解和文本模型。

泓君:通过眼镜订咖啡已经实现了吗?

徐栋:准确说,早就实现了。千问App通过自然语言可以点咖啡、完成商业闭环,全部在一个基于大模型的架构里面去完成。我刚刚试过,它会生成卡片,如果大模型操作界面和原来App一样,可能会有挑战,推荐咖啡时会考虑距离、偏好、历史选择,因为戴眼镜时希望AI懂我、有记忆,这样更方便。你可以切换,点开就是完整菜单。

泓君:我们可以看看未来这类应用的发展情况。今天我们主题是大模型商业化,你能否整体介绍一下阿里千问是如何商业化的?

徐栋:做大模型与做云的最大区别是,云的覆盖是比较慢的,最早是手游,慢慢覆盖到金融和制造业。大模型这一波的改变是全行业覆盖,每个行业都在用,只是渗透率不同,我们从两个方向看:

第一,模型与企业结合,提升企业生产力。企业内部有很多流程和角色,大模型可以在设计、编程、研发、销售等环节发挥作用。

第二,产品与大模型结合。很多互联网公司和消费电子硬件天然与用户交互,经过大模型改造后,交互体验发生很大变化,产品定位发生根本改变,所以我们与之有深入合作,不仅限于云上合作,像一些手机和车厂有低延时和本地化需求,我们发布了Omni模型(4B参数),他们对这类端侧模型很感兴趣。

泓君:这是类似卖端侧模型吗?

徐栋:是。这个场景更多针对算力较强的手机厂商和车厂,毕竟涉及功耗、发热等问题。经过两三年打磨,很多车厂和手机厂开始考虑端云结合架构。因为需求越来越旺盛,仅靠云模型不够,我们今天已经进入到一个深水区了,端云模型结合,都成为大家关心的话题了。

泓君:从消费者视角看,未来每部手机甚至每辆车都可能具备智能化交互能力,变得很智能,它是一开始就嵌入到手机里的。

徐栋:对,智能设备是每个人的贴身入口,涉及隐私、高时效性任务,所以一些硬件厂商的规划里就会考虑这些因素。

泓君:我们把比如Omni的这个模型,放到一个手机或者是一个车里,它有一些任务是在云上处理的,会接入阿里云,还是客户自己的云?

徐栋:绝大部分企业,基本上都在阿里云上面提供这样的云服务,通过MaaS服务平台“百炼”直接与设备交互。这个平台的核心要求就是高并发、低延时、可观测,支持鉴权管控,是一个相对完整的平台。可以理解为绝大多数企业通过这个平台连接业务。

泓君:什么场景可以直接在端侧处理?什么场景移到云上?端侧跟云,大概会占到一个什么样的比例?

徐栋:这是动态变化的。现在端侧模型效果比两年前的百B模型还好,现在只要一个4B的模型可能就效果发生改变。通用类任务、基本交互任务、语音和视觉理解,七成以上可以由端侧模型较好地去解决了。

泓君:客户与阿里合作时,最关心什么问题?

徐栋:这是一个变化过程。最早关心的是效果,因为模型效果还不够好,客户会提很多垂直任务,构建评测集。最近半年到一年,客户从效果转向性能和成本。因为我们的模型体量增长了几十倍,客户也进入了严肃的生产环节,模型效果基本得到验证了。

客户关心TPS、首包延时,甚至精细化到4K输入和10万输入,有分别不同的TPS跟首包的要求。

有些业务有高并发需求,比如智能外呼,半小时内完成10万通电话,对并发要求很高。

最后是成本,当使用量增长几十倍、上百倍后,成本势必成为客户非常关心的话题。像一开始说到的视频生成模型,目前还比较贵,如果客户要批量生成自动化的广告,他对成本诉求也会进一步提高。

泓君:听起来客户对行业理解已经很深,知道什么场景用小模型,什么场景用大模型。我感觉行业商业化已经不是起步阶段,大家开始提出具体需求,对垂直细分和精细化程度有了更多的考量。

徐栋:是的,最近小模型需求特别多,重复性的任务,用小模型会更有性价比。意图理解、意图抽取等场景,很多企业的Chatbot或Agent第一步就是对用户的理解和判断,这方面小模型需求也很多。中小模型的post-training(后训练)或fine-tuning(微调)需求最近三个月开始越来越多,客户希望基于闭源模型混合自己的数据,训练出适合他的小模型。

泓君:成本是大家非常关注的。从阿里角度看,推理成本降了多少?

徐栋:推理成本基本上每半年下降近一个量级(十倍)。成本下降受多个因素影响:

第一,模型结构稀疏化、混合精度、MTP等技术的应用。

第二,芯片与模型的垂直一体化设计带来潜在红利。

第三,调度优化,提高利用率。我们通过不同模型切换、时间段任务切换、夜间跑批任务等,带来了利用率的提升。利用率非常高的话,成本就会下降。

补充一个具体案例吧,2025年底我们发布了Qwen3-Next,一个80B参数、3B激活的模型,稀疏比很高,相信很多开发者已经试过了,它的推理效率、效果和速度都有很大提升。

泓君:除了模型结构和算法,芯片设计和软硬一体化对推理成本下降非常有帮助。谷歌TPU早期推理成本是OpenAI、Anthropic的十分之一,就是因为它是根据模型算法专门去设计的。

徐栋:所以我们看阿里巴巴的科技板块,有云、有模型,有芯片的投入,三位一体,听起来和谷歌有点接近。垂直一体化的好处很多,不仅是芯片和模型,还涉及到云,比如刚刚说的调度优化,就是跟云相关的。

泓君:我注意到你们是全球最全面的开源大模型,当时为什么决定开源?

徐栋:2023年8月前后,我们的7B模型得到非常大的市场反馈,基于这个模型,我们打开了全球格局。千问和万相在海外社区活跃度很高。开源有几个好处:

第一,增强人才吸引力,很多顶尖科研工作者或学生在学校就开始用千问模型,对其特性很了解。

第二,社区反馈帮助我们快速迭代,早期的时候非常明显,社区里面包括推理框架、推理引擎,甚至端侧部署等开发者围绕生态帮我们做建设,提出的数据集和失败案例问题,对我们模型快速迭代的帮助非常多。

我们在开源这块是投入非常大的,国内外企业几乎没有开发者不知道千问,企业内部或多或少都会用到千问的一些能力。尤其是我们开过小参数模型,如1.5B、3B以下,我们还有一个最“甜点”的模型是32B(单显卡可运行),在企业中有大量应用。

图片来源:Hugging Face

泓君:开源和闭源,你们怎么做商业化平衡?客户拿到开源模型就可以免费用,闭源模型是有商业化收入在里面的。

徐栋:首先,阿里云是一家云公司,开源对我们云业务的带动非常明显,形成了商业化的正循环。第二,开源模型在发布时是离线版本,我们会在API版本(闭源)会进行修正和能力提升。很多开源生态用户也希望使用更简单易用、并发更高的MaaS服务。另外,开源模型考虑开发者易用性,参数不会太大。我们最大的模型千问3 Max没有开源,因为部署成本很高,有需求的客户会选择千问3 Max。

泓君:2025年春节前后,DeepSeek发布开源模型,让中美眼前一亮。你觉得他们的发布对阿里有冲击吗?包括商业化方面。

徐栋:市场还处于中早期阶段,更多模型公司推动技术进步是最重要的。他们的论文清晰有参考意义,对整个行业是很好的推动。开源后反而带动了开源生态活跃,让千问开源得到进一步发展。千问从0.5B到235B版本跨度大,企业不同场景都可以用到,更新节奏快,基本上我们一个月发三个小版本,三个月到半年发五个左右的大版本。这是一个相互促进的过程。

泓君:今年大家讨论如何衡量应用是否火爆,行业常用方法是看用了多少Token。你觉得未来如何评价大客户或火爆应用?Token量是合理的评估指标吗?

徐栋:我认为阶段性有参考意义,很多公司用Tokens衡量创业估值,但长期来看,一定会回归到收入,不一定是Token直接带来的收入,也可能是封装成Agent的收入。我们内部探讨Model As Service(模型即服务)和Agent As Service(智能体即服务)。Tokens有一些弊端,比如最小模型和最大模型的成本、收入可能差1000倍,商业价值也会有很大不同。再比如说多模态,语音模型和文本模型的Token度量衡也没有清晰地统一起来。但Token依然是目前观察业务使用量的较好指标,我们比较关注。

泓君:Model As Service(模型即服务)和Agent As Service(智能体即服务),有什么区别?

徐栋:Model As Service强调的是模型的服务能力,比如你能不能时刻推出最新的模型、你的API应用性是否足够高,包括实时API、跑批任务等,这些都是它衍生出的很多产品的用法。

Agent As Service可能按场景或行业划分,它可能用到多个模型,最后封装出标准的任务结果给客户使用,比如Deep Research就是一种智能体即服务能力。

泓君:你觉得现在大家在大模型研发上的投入还多吗?我指的是基础大模型最前沿的、性能最高的、再把模型推向极限的模型研发。我的感受是,现在大家也关注模型进化,但讨论热度不如商业化高。

徐栋:这可能是一个小的反共识,或误区。从模型角度看,我觉得模型研发投入反而变大了。市场上每家公司、实验室都说自己缺算力,这意味着他们的工作结果可以被定量衡量的,这是一个高度竞争的过程。只是它可能不像过去那么显性,比如突然推出o1模型,它具有推理能力了,或者突然有了Nano Banana,它可以做编辑了。

现在模型进入精耕细作阶段,可能没有太多极端的范式上的改变,但是有大量工程细节需要推敲。所以为什么成本在以量级下降?就是因为可以做的工作太多了,比如数据清洗、评价标准等,过去用规则,现在可以用模型,有大量细节工作可以做。

泓君:现在模型研发主要表现在哪些方向?刚才我们讲到了多模态是大家关注的重点,去年Agent大爆发,比如在Coding Agent方面,Anthropic和硅谷几家大的模型厂商在代码提升方向放了更多数据配比和优化。你觉得未来行业趋势中,大家的模型研发在拼哪些方向?

徐栋:笼统讲是Agentic能力。Agent或者Agentic这个词,每个人定义都不一样。从结果表现看,我期待的是一个模型能连续运行两个星期,并拿到好结果。在这个过程中,它需要与环境不断交互,它需要自己做思考判断和假设。这样的模型结果一定会是非常棒的。回到一开始讲到的语言模型的投入方向:工具调用能力、上下文能力、复杂指令遵循能力、推理能力。这些能力不断提升,组合起来会带来实际业务落地的很大改变。

泓君:所以主要是精耕细作,而不是在模型智能上?

徐栋:对,这取决于智能的定义。如果智能可以打分,这些精耕细作都是让智能分数越来越高。

二、从全景理解到自动剪辑

泓君:亓教授先来讲一下,你们Insta360的产品是怎么样跟AI结合的?

亓鲁:我们是一家影像公司,使命是让用户更好地记录和分享生活。所以与阿里的合作中,比较典型的是云端自动剪辑。我们希望用户拍了一天或一整年的素材,能够智能地剪辑成一条拿得出手或愿意分享的视频,这对我们公司的战略非常关键。

泓君:影石是我非常喜欢的公司,亓教授您可不可以详细讲一讲,你们是怎么用到AI工具在视频剪辑中的?

亓鲁:自动剪辑本身是一件特别主观、玩法比较多的事情。难点不是把用户片段拼起来,而是能命中用户的剪辑意图。不同人喜好不同:有的用户在意故事延续性,希望视频像一部小型纪录片;有的用户想要高光瞬间,让影片节奏更快;还有的用户注重氛围和表达,比如配乐情绪、镜头语言、转场风格。

所以我们与阿里的合作主要集中在两个方面:一个是千问的多模态理解模型,另一个是万相的视频生成模型。前者偏感知和理解,后者偏特效生成。

泓君:假设我给AI工具输入指令:“剪辑我所有从雪山滑下来失败的瞬间。”它首先要理解语义,其次要在视频里分析哪些是失败的瞬间。

亓鲁:对。我们的多模态理解负责看懂用户素材,理解每个片段发生了什么,进一步做高光提取、人物与事件判断,最后将片段以结构化形式编排,让素材成为有逻辑、有主线的内容组合。

泓君:你觉得现在整个模型的能力,它能理解到哪一步?能剪辑到哪一步?

亓鲁:现在多模态理解在语义层面能满足一定需求,更大的问题是如何进行用户意图识别。用户意图可能与素材无关,更多是用户行为或给出的指示词。但很多时候用户自己也不知道如何表达想剪辑成什么样。这是一个比较大的难点:怎么让剪辑算法理解用户到底想要什么。

泓君:就像用户是不是一个好甲方,能否让乙方清楚理解意图。比如“失败的瞬间”可能不够,要说“从雪橇上飞出来的画面”,给出更清晰客观的定义,是这一步很难吗?

亓鲁:对。如果要求用户给出清晰定义,那这个体验也会很差。我们更希望用户用模糊语句,我们就能理解。这在模型层面还比较难。

泓君:在你们用AI做影片时,推出了哪些具体功能?如何用到多模态的?可以跟大家讲一讲吗?

亓鲁:影石最核心的产品是全景相机,秉承“先拍后剪”理念:拍摄时用360度全角度覆盖记录现场,剪辑时再挑选最佳视角、最合适节奏,把内容讲成故事。

全景素材与普通广角相机不同,是360度全景图。虽然通用大模型在预训练阶段会用到360度素材,但在海量平面素材面前,全景数据量就显得很少,导致模型对360度全景素材理解较差。

影石会分为自研和调用API两部分。我们通过自研的全景理解模型,先对全景素材进行高光提取,这是影石的核心技术壁垒,然后接入通用大模型进行平面内容编排。

泓君:哪部分自研,哪部分调用API?补充一句:从全景相机中提取可用素材,这个需求很硬核,因为你有一个主方向,可能三分之二素材是没用的。

亓鲁:如果是360度素材,即使场景相对单一,加上各种运镜玩法,也可以让素材更为生动。我们自研的部分主要是基于全景的多模态理解模型,后面更倾向于用通用大模型帮助理解平面素材。

泓君:比如用户拍一段三分钟左右的360度视频,AI把最有亮点的环节剪出来,大概消耗什么成本?卡在哪?成本下降的核心驱动力是什么?

亓鲁:用户剪一段这样的素材可能需要十几块钱成本,还是蛮贵的。我们希望在技术上解决,包括对模型输入做更高的信息压缩,因为全景素材可压缩率较高。我们更希望结合全景特性,从技术手段上把Token数量压下来。

三、不止是降本,更是增效

泓君:接下来聊第二个案例,语忆科技如何帮助大型零售公司用AI提升业务能力。吕总,我知道雀巢、宝洁、泡泡玛特等都是你的客户。可以先介绍一下你们主要做什么吗?

吕瀛杰:我们是为国内和跨境消费品牌提供全域消费者洞察分析的、AI ToB的一家SaaS公司。

泓君:可以分享一下你们怎么做AI,怎么与客户合作吗?

吕瀛杰:以前,中国消费品电商企业主要运营方式是通过产品买流量直接转化客户,非常依赖流量红利。2023年后,流量红利见顶,很多头部企业逐渐意识到要从流量思维进化到“流量+消费者思维”,这就诞生了大量消费者调研需求。

企业在电商领域有很多消费者与客服沟通的数据,很多客户曾用大模型直接对原始数据进行意图理解和抽取,但他们自己做准确率连70%都达不到。

我们想帮他们解决这个问题。我们从2021、2022年开始用GPU跑显卡,做了一个非常垂直的、针对不同行业的消费者意图识别小模型。客户希望我们对原始语料打标,打出消费者画像,并且识别意图,帮他们搭建意图识别Agent。

这些画像不同于传统投流用的年龄、职业等,而是与产品兴趣直接相关,比如一个头部美妆品牌,希望了解消费者肤质情况、使用产品后的反馈、是否过敏等。

泓君:这些信息怎么收集?我觉得这些信息很有用,比如我买护肤品或化妆品时,觉得选择太复杂,研究清楚要花很久。

吕瀛杰:比如您买东西时,我们会让客户在接待话术中做埋点改造。客户进线后,客服主动说:“我是您的护肤美妆顾问,为了更好地推荐产品,希望了解您的肤质情况。”这样改造后,消费者提及率会高很多。

这是一个方向。在处理过程中我们发现几类意图:第一类是消费者画像;第二类是消费者对产品、服务、物流、营销的反馈(正面或负面);第三类是归因,举个例子,一个国内顶级日化品企业,原来有六个员工人工登记退货原因,对应责任部门,用于绩效评定。我们帮他们搭建Agent归因模型后,现在只有一个人复审。

泓君:你们与这些企业合作,他们用AI有好几层动力。我们可以一个一个分析,取代客服可能是最常用的AI功能,你觉得效果好吗?

吕瀛杰:我们不觉得是完全替代客服。客服工作流分售前接待和售后处理。售前接待中,客户问产品问题,大模型经过知识库训练校准后,回答准确率可能比人还要好,非常棒。但客户的真实咨询场景更复杂,比如客户问优惠券,大模型可能直接回答金额,但客户接着问浙江地区能否参加国补,大模型再调取政策,如果再复杂到怎么凑单最能优惠,这样延展下去,AI的准确率可能就不够好。

泓君:在这些环节中,你们与基础模型如何合作?以千问大模型为例,它们提供哪部分能力?

吕瀛杰:基座模型能提供消费者问题的意图识别。其次,普遍做法是为客户搭建AI知识库,通过大模型识别意图后,进入下一个工作流,用RAG方式获取外挂知识库。此外,大模型对知识库清洗也有很大帮助,因为企业内部知识可能不是标准化文档,可能有详情页图片、Xmind工作流等。这么多复杂的知识源,都需要大模型梳理到知识库中。这也是基座模型能力的重要体现。

泓君:你们选模型时最看重什么?是基座模型能力,还是调用接口?

吕瀛杰:我们的核心是帮品牌做消费者意图识别理解,所以非常看重基座模型在这方面的能力。我们也有一些跨境的客户,也有一些多语言的数据,我们测试过国内外模型,发现阿里的千问在电商场景的消费者意图理解能力还是比较强的。

泓君:你们的位置很有意思:上游是基座模型,你们是中间层,下游连接想应用AI的企业客户。你觉得这些客户用AI是为了省成本还是增销量?是做存量还是增量市场?

吕瀛杰:这是个动态发展的过程。2023年大家探索如何用AI帮助企业时,非常关注降本。但去年市场变化很大,很多企业发现用AI自动化节省一些人工,虽然能打平用人成本,但也没有带来特别大的效益价值。2024年下半年开始,越来越多企业想用AI增效,希望AI去帮他们发现深度的产品机会、消费者需求点,或老产品的新场景。

举个例子,一个国内顶级家电品牌的高端产品线(客单价2万以上),通过我们提供的AI消费者画像识别和产品反馈分析,针对客户功能需求设计营销卖点、主播话术、客服话术。合作一年半后,整体销量涨幅23%,高端线产品客单价提高6%以上。因为我们和这一个事业部合作效果很好,2025年他们把我们推荐给整个集团,每个事业部都接入了AI识别模型和SaaS产品、Agent能力。

泓君:像你们这样一端连模型、一端连客户的中间服务层,核心竞争力是什么?是对业务的理解深度,还是技术能力?

吕瀛杰:我们两方面都有。我们会训练针对不同行业意图识别的模型,形成自己的数据飞轮。客户看到的是意图识别标签和成品Agent,但我们会留存数据训练垂直模型,在意图识别场域越来越准,尤其是对同类目的客户。

更重要的是,客户希望我们不仅是技术供应商,还能以行业专家的身份提供行业know-how,比如头部企业如何应用AI产品,所以我们的客户成功团队(CSM)也会配置不同行业的专家提供服务。

泓君:有个更未来的问题:AI在意图识别后匹配更精准商品,确实能带来销量提升和转化。那么随着越来越多行业和大品牌把AI打入工作流和销售环节,最终所有企业都用上AI后,效果会不会慢慢变弱甚至追平?我们现在是否还在红利期?

吕瀛杰:这个问题有意思。大家都升级军火库后,还有什么竞争力?我认为AI未来的价值核心还是掌握在人手里,看如何使用它。在意图识别、方向匹配、Deep Research报告生成上,各企业可能大体一致。但最终决策者如何看待这些数据、挖掘AI处理后的洞察,非常看人的洞察能力。最后还是要人找到真正的机会点。

泓君:这个总结特别好。现在是在AI红利期,越往后归因,未来真正的好产品才最具竞争力。

吕瀛杰:对。所以好的产品经理、好的伙伴永远有机会。我再提个题外话:AI对To B SaaS行业在客户收费意识教育上起到了非常好的效果。以前中国To B企业客户付费意愿和金额不高,因为他们认为谁都可以做软件,价值不大。但AI这波影响很大,客户明确认识到AI按Token计费,用了多少数据量就有相应成本,如果不付钱,就无法提供服务。在付费意识这块,我们也在朝着美国To B市场同步。

本文来自微信公众号:硅谷101,采访:泓君,图文:泓君、朱婕

。